Генеративные модели ИИ нередко воспринимают как умных помощников: задал вопрос – получил ответ.

Однако в бизнесе тех, кто действует по такой упрощенной схеме, результат зачастую разочаровывает. Модель пишет общие фразы, додумывает какую-то информацию, предлагает результат, который нельзя применить без скрупулезной редактуры. Но проблема не в технологии как таковой, а в способе ее использования. Чтобы правильно ее применять, важно понимать, как она работает.

В этой статье мы разобрали генеративные нейросети через пять типовых бизнес-сценариев:

Каждый сценарий показан пошагово: от подготовки данных до проверки второй моделью. Все данные и примеры в промптах вымышленные и используются только для демонстрации механики работы. Чтобы показать, как работают генеративные модели, мы воспользовались сервисом GPTunneL , где собраны лучшие ИИ-системы.

Генеративный ИИ — это инструмент, который создает новый текст, идеи и структуры. Он превращает ваш запрос в набор сигналов о смысле, стиле и формате, а затем шаг за шагом выбирает следующую фразу так, чтобы она была согласована с контекстом и языковыми закономерностями, которые он усвоил на огромном количестве примеров.

Грубо говоря, это рекомбинатор языка в масштабе всего интернета: он собирает новый текст из типовых паттернов логики объяснения, аргументации, делового письма, инструкции, резюме. Отсюда двойственность, которую мы покажем в 5 примерах ниже: он умеет быстро строить связный черновик и находить правдоподобные связки, но при слабых опорах в данных легко заполняет пробелы формулировками, которые звучат убедительно, хотя могут быть неточными или просто чрезмерно общими.

Важно разделять два этапа: как модель обучили и как она отвечает в диалоге.

На этапе обучения нейросеть анализирует огромное количество текстов и учится распознавать типовые закономерности: как строятся фразы, аргументы, объяснения и стили.

Когда пользователь задаёт вопрос, модель:

Из этого можно сделать вывод: применение генеративного искусственного интеллекта нельзя полностью унифицировать. Он приносит пользу, когда встроен в частный рабочий сценарий с развернутой, понятной задачей, входными данными и проверкой результата. Дальше покажем, как использование генеративного ИИ работает на практике.

Во всех примерах из этой статьи мы используем один и тот же рабочий шаблон. Мы демонстрируем не ответ модели, а процесс с управляемым результатом. Работа ведется в агрегаторе GPTunneL, где можно запускать разные модели в одном сценарии и разделять генерацию и контроль. Одна модель создает результат, вторая проверяет и ограничивает его. В каждом сценарии можно увидеть:

Задача – показать, что технологии генеративного искусственного интеллекта работают только как часть процесса, а не в формате «один запрос – один ответ».

Входные данные:

«Ты senior B2B-маркетолог с опытом SaaS-продуктов. Сформулируй 5 гипотез рекламных сообщений для digital-кампаний.

Требования:

Формат – таблица со столбцами:

Исходные данные приведены выше».

GPT-5.2 сделала 3 полезных вещи:

Слабые места:

Определенно нужна редактура с помощью второй модели.

Просмотреть результат можно в диалоге.

«Ты бренд-редактор B2B-компании.

Проверь гипотезы:

Усиль формулировки, не меняя смысл. Здесь нужно вставить ответ предыдущей модели».

Claude значительно переработал текст, не исказив его смысла. Модель сделала следующее:

По итогу текст стал короче, жестче, оказался более оптимальным для тестирования. А доступен этот текст по ссылке.

Данные:

«Ты опытный B2B sales manager. Ситуация – клиент перестал отвечать после демо. Цель – вернуть диалог без давления. Ограничения:

Контекст приведен выше».

GigaChat создала вежливый и максимально безопасный follow-up. Он оказался нацеленным скорее на возобновление контакта с клиентом, а не на продвижение сделки. Конкретно GigaChat сделал следующее:

Итог: письмо подходит для «пинг-контакта», но без дополнительной редактуры никак не продвигает диалог. Для продаж нужны будут дополнительные правки.

Чтобы ознакомиться с письмом, заходите в этот диалог.

«Ты руководитель отдела продаж. Проверь письмо:

Сделай письмо короче и конкретнее».

Claude 4.5 Sonnet радикально переработал письмо, но сохранил общий смысл послания. Нейросеть:

Проверить работу модели можно тут.

Данные:

«Ты product manager B2B SaaS. Подготовь черновой план реализации фичи. Формат – таблица со столбцами:

Учитывай сроки и ресурсы».

GPT-5.2 предложила полноценный операционный план. Искусственный интеллект:

Ограничение: план слишком детально проработан для раннего черновика и требует проверки сроков техлидом. Без этого остается риск в заданные сроки не уложиться.

Оценить работу GPT можно в тестовом чате.

«Ты tech lead.

Проверь план:

Укажи риски и предложи правки».

Claude провел полноценный техлид-обзор. Нейросеть:

Итог: оптимистичный план трансформировался в реалистичную дорожную карту с управляемыми рисками, а сроки увеличились до трех недель.

А результат можно проверить тут.

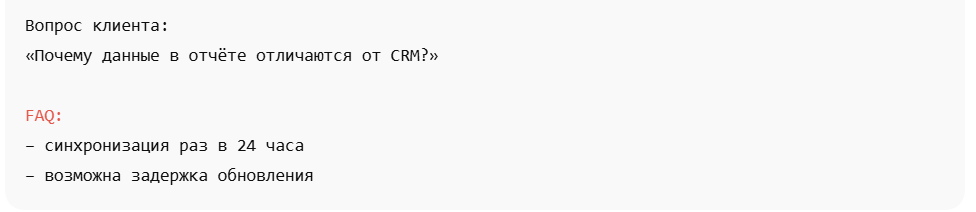

Данные:

«Ты специалист службы поддержки. Ответь клиенту простым языком.

Ограничения:

YaGPT-5.1 Pro предложила корректный, но очень упрощенный ответ специалиста. Проблема этого ответа в том, что он объясняет, почему у клиента возникла проблема, но не подсказывает, как ее решить.

Нейросеть точно указала источник расхождений: синхронизация данных происходит раз в 24 часа. Ответ фактически верен, не содержит домыслов и не кормит клиента ложными обещаниями. Формулировки безопасные и нейтральные.

Но есть и негативная сторона: нет указаний на то, что делать клиенту. Не сказано, где проверить статус обновления, когда писать повторно и что делать, если данные не синхронизируются через 24 часа.

Эмоциональной вовлеченности, которая снизила бы тревожность клиента, в письме также нет.

Оценить ответ техподдержки можно, пройдя по ссылке.

«Ты руководитель службы поддержки.

Проверь:

Gemini 3 Pro предложил качественный анализ через призму сервиса и эмпатии. Модель:

В результате получился отличный саппорт-ответ, нацеленный на то, чтобы снизить тревожность клиента и избавиться от риска повторного обращения. Ссылка на ответ тут.

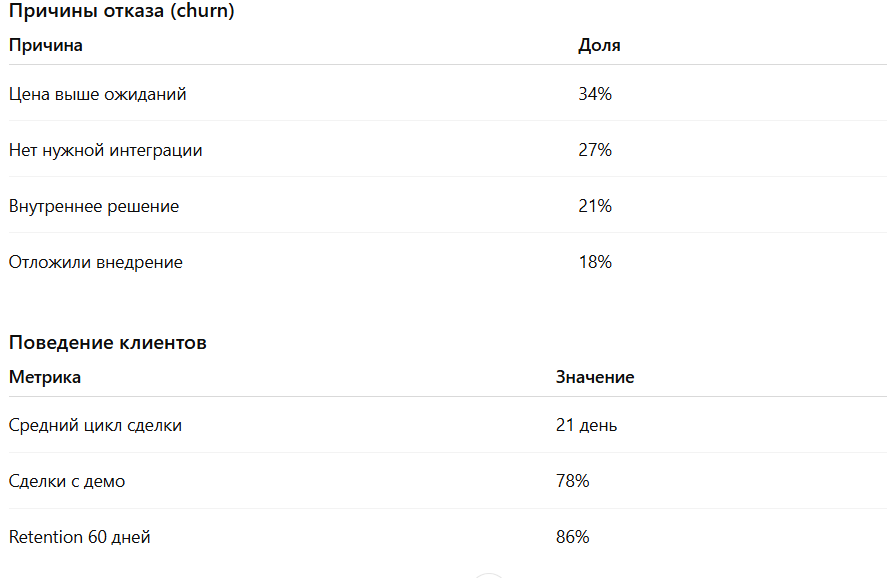

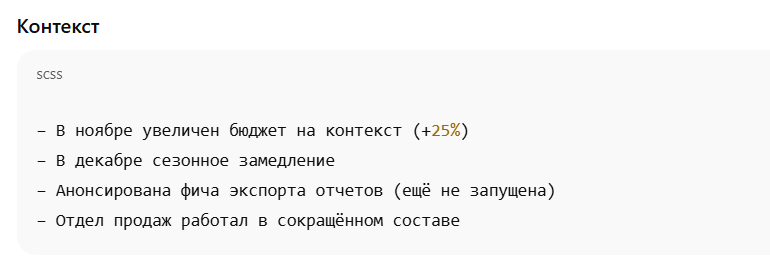

Данные:

«Ты бизнес-аналитик. Ниже приведены агрегированные данные продаж за 3 месяца. Подготовь управленческое резюме для руководителя.

Формат:

Важно:

Данные приведены выше».

Что конкретно сделала модель:

Слабое место: модель делает интерпретацию («ценностное предложение не соответствует рынку»), которая требует проверки вне предоставленных данных.

А здесь – результат.

«Ты SEO-специалист компании. Проверь резюме:

Укажи слабые места».

Модель выполнила строгую проверку, а не пересказ ранее сгенерированного текста.

Резюме из диагностического стало управленческим фильтром: что можно решать, а что – нет.

Просмотреть анализ вы можете здесь.

Во всех примерах хороший результат появился не потому, что модель работает безупречно, а потому, что мы разделили роли. Одна нейросеть генерирует, другая – проверяет, режет, уточняет, переформулирует. Это принципиально разные задачи, и далеко не каждая нейросеть может хорошо выполнить конкретную.

Генеративный ИИ в бизнесе – это воронка, а не «один удачный запрос». Пока генерация и контроль не разграничены по шагам и моделям, результат будет случайным и рискованным.

Выберите один сценарий. Ваша задача – не внедрить генеративные системы искусственного интеллекта глобально, а сформулировать конкретную задачу: письмо продаж, ответ саппорта, резюме отчета.

Если же вас интересует системный подход и вы хотите обучить сотрудников работать с ИИ по подобным сценариям, GPTunneL предлагает пошаговое обучение и консультации. Практические задачи, приближенные к кейсам компании, освоение нейросетей с нуля, бонусы для неограниченного тестинга – вот что ждет вас и ваших сотрудников.

Генеративный ИИ – это механизм, который при грамотном использовании демонстрирует высокую эффективность. Главное – выстроить вокруг него последовательный процесс: давать нейросети развернутые данные, четкие задачи и, конечно, комбинировать модели для проверки результатов. Только такой подход превратит генеративный искусственный интеллект из экспериментальной инновации в полноценный рабочий инструмент.