Представьте себе нейросеть, которая работает в два раза быстрее флагманских моделей, но при этом не теряет производительность. Claude 4.5 Haiku от Anthropic — быстрая модель ИИ, которая меняет представление о том, как должны балансироваться скорость, интеллект и стоимость. В этом обзоре Claude 4.5 Haiku:

Эта модель с поддержкой рассуждений и контекстным окном в 200,000 токенов доступна для российских пользователей через GPTunneL без VPN и лишних подписок. Протестируйте модель прямо сейчас, чтобы узнать ее возможности самостоятельно! Стоимость использования модели можно посмотреть на нашей странице цен.

Для понимания того, почему Claude 4.5 Haiku стала значительным шагом вперёд, нужно понять, какие технические улучшения её отличают. Каждое изменение — от поддержки рассуждений до осознания контекста — имеет практическое значение для ваших задач.

Haiku 4.5 — первая модель в своей серии, которая поддерживает расширенные рассуждения в формате цепочки мыслей (“chain-of-thought”). Они позволяют ей думать над проблемой с разных точек зрения в несколько шагов, прежде чем отвечать. В GPTunneL вы можете назначать бюджет для рассуждений:

Возьмём практический пример. Вы даете нейросети задачу: «Проанализируй, почему стартапы в сфере AI получают больше инвестиций, чем компании в других отраслях, и какие риски это несёт?». Вот, как модель ответит при разных уровнях размышления:

Claude 4.5 Haiku работает с контекстным окном в 200 000 токенов, как и другие нейросети в семействе, и может генерировать до 64 000 токенов за один раз — в восемь раз больше, чем 8 196 токенов у Claude 3.5 Haiku.

Это значит, что вы можете загрузить 100-страничный годовой отчет и спросить: «Найди все пункты, связанные с досрочным расторжением, и укажи, есть ли в них противоречия». Модель прочитает весь документ и даст точный ответ, не забыв детали с первых страниц.

Согласно системной карте модели, Claude Haiku 4.5 специально обучена отслеживать использование контекстного окна, что позволяет ей избегать «лени» — преждевременного прекращения работы над задачей. Вот перевод того, что говорят разработчики об этом в своем документе:

«Мы обучили модель Claude Haiku 4.5 явно учитывать контекст, с точной информацией о том, сколько контекстного окна было использовано. Это имеет два эффекта:

Мы обнаружили, что это вмешательство, наряду с другими, эффективно ограничивает «лень» агента (феномен, при котором модели преждевременно прекращают работу над проблемой, дают неполные ответы или упрощают задачи)».

Мы дали ей сложный многосоставный запрос: «Проанализируй этот код на Python, найди потенциальные утечки памяти, предложи варианты оптимизации и перепиши самый проблемный участок с комментариями». Посмотрите ответ в нашем чате!

Вместо того чтобы остановиться после первого шага, модель выполнит все четыре:

Модель также соответствует стандарту AI Safety Level 2 (ASL-2), демонстрируя меньше нарушений и более безопасное поведение. На практике это означает, что при обычном общении она с меньшей вероятностью создаст оскорбительный или опасный контент, делая взаимодействие более предсказуемым и надежным.

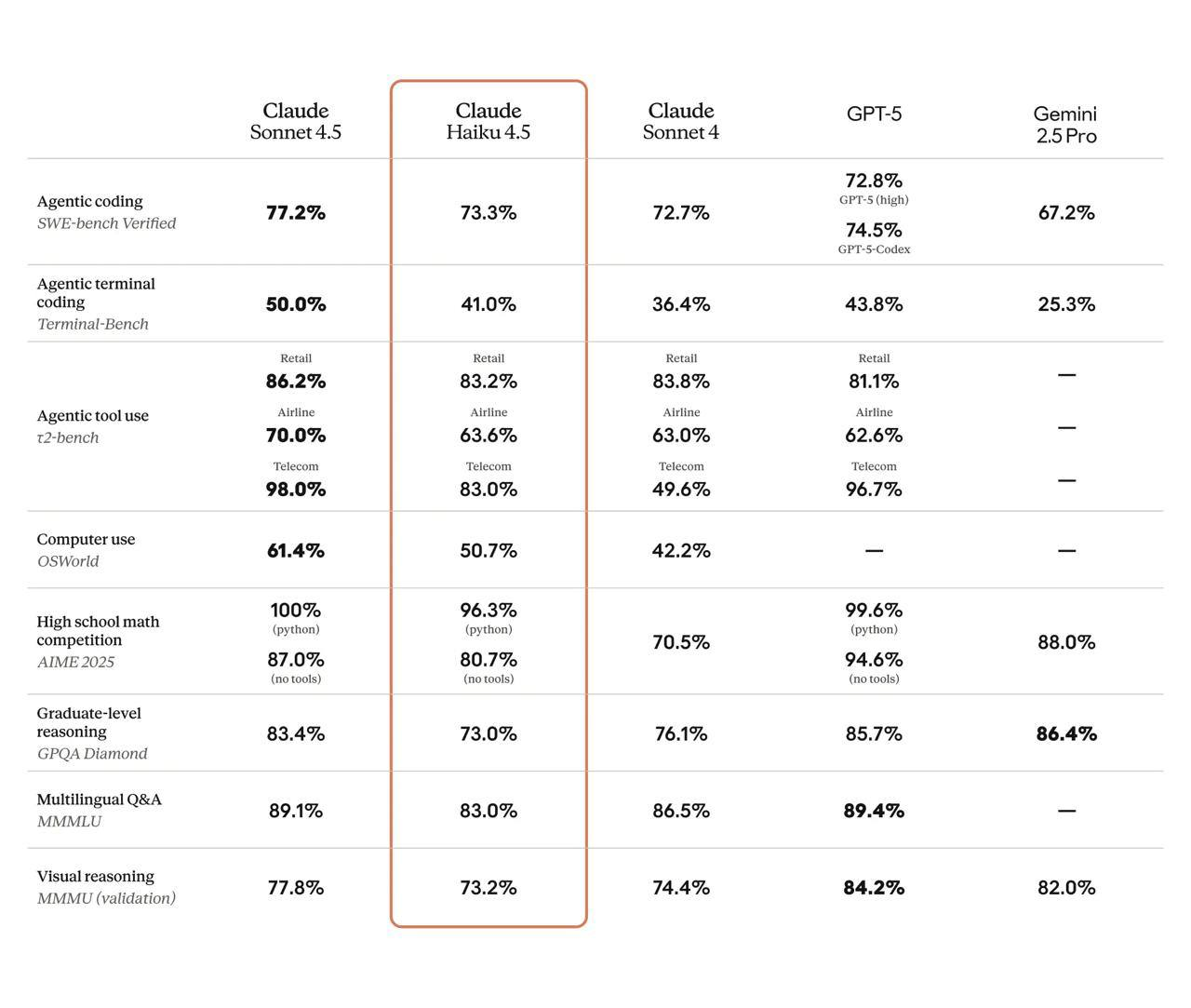

Числа в бенчмарках — это не просто статистика, а показатели того, как модель будет справляться с вашими реальными задачами. Claude Haiku 4.5 демонстрирует результаты, которые ещё недавно были доступны только дорогим флагманским моделям.

Несмотря на то, что Claude Sonnet 4.5 остаётся флагманской моделью Anthropic, Haiku 4.5 достигает 90% от его производительности в задачах по размышлению и кодированию, но работает быстрее. По независимым тестированиям от Artificial Analysis, модель показывает среднюю скорость вывода ответа более 100 токенов в секунду при выключенном режиме рассуждения. Это делает Haiku 4.5 оптимальным выбором для баланса между скоростью качеством.

Теория становится ценной только когда вы видите конкретные результаты. Ниже — реальные сценарии, где Claude 4.5 Haiku раскрывает свои сильные стороны, с примерами промптов для каждого случая.

Промпт: «Вот мой Python-скрипт для парсинга логов веб-сервера. Он использует регулярные выражения и работает очень медленно на файлах > 1 ГБ. Задание: 1. Перепиши его, используя pandas.read_csv для скорости. 2. Добавь обработку исключений try-except для случаев, когда строка лога повреждена. 3. Напиши docstring для новой функции, объясняющий, что она делает, какие аргументы принимает и что возвращает».

Посмотрите ответ в нашем чате!

Модель показывает высокую компетентность в создании и модификации кода. Ее скорость ответа позволяет быстро итерировать, получая оптимизированный код почти мгновенно, что делает ее выгодным инструментом для ежедневного использования.

Промпт: «[Отчет McKinsey об азиатском рынке на 84 страницы] Задача: Проанализируй отчет McKinsey о выходе на азиатские рынки с точки зрения бизнес-стратега. Мне нужна сжатая и структурированная выжимка для принятия решений.

Сфокусируйся на следующем:

Представь результат в виде четкого списка с заголовками. Будь краток и по существу». Посмотрите ответ в нашем чате!

Способность обрабатывать до 200 000 токенов позволяет аналитикам загружать целые отчёты и исследования в одном чате. Модель находит взаимосвязи и извлекает ключевую информацию из огромного массива данных, экономя часы ручной работы.

Промпт: «Источник: [Статья про Claude 4.5 Sonnet в GPTunneL]. Задача: На основе статьи создай пакет контента для анонса. 1. Напиши два твита с местами для ссылок. 2. Составь пост для LinkedIn, ориентированный на технических специалистов. 3. Подготовь яркое и неформальное сообщение для нашего Telegram-канала с использованием эмодзи». Посмотрите ответ в нашем чате!

Для контент-менеджеров модель выступает как «контент-фабрика», генерируя несколько вариантов текста для разных платформ и сохраняя при этом логику. Это позволяет быстро адаптировать одну новость под разные каналы коммуникации.

Промпт: «Представь, что ты репетитор по физике, а я — ученик, который не понимает второй закон Ньютона. Объясни мне его суть на простом примере из жизни (например, с тележкой в супермаркете). После своего объяснения задай мне один-два вопроса, чтобы проверить, как я понял. Не давай сразу все ответы». Посмотрите ответ в нашем чате!

Для образовательных целей мгновенные ответы создают эффект живого диалога с репетитором. Высокий уровень безопасности гарантирует, что образовательная среда будет свободна от неуместного контента, а способность к рассуждениям помогает модели адаптировать объяснения и проверять понимание.

Вы изучили технические возможности, увидели бенчмарки и познакомились с практическими применениями. Теперь — время действовать и испытать модель на своих задачах. Протестируйте модель, чтобы лично оценить её производительность и скорость. Claude 4.5 Haiku представляет собой сочетание скорости, интеллекта и доступности, что делает её универсальным инструментом для широкого круга задач.

В GPTunneL вы можете начать работу без сложных настроек, VPN и международных подписок. Модель доступна в нашей библиотеке нейросетей и при работе с ИИ-ассистентами.